Firma Stone Temple Consulting potwierdziła przypuszczenia użytkowników. Asystent Google jest najlepszym wirtualnym asystentem na rynku. Pod lupę wzięto 4 najważniejszych graczy: Google, Apple, Microsoft i Amazon. Odpowiednio przetestowano ich produkty: Asystent Google, Siri, Cortana i Alexa.

To cię zainteresuje:

- Wiemy kiedy Asystent Google pojawi się w Polsce.

- Świetna promocja na przystawkę z Android TV.

- Jak włączyć nowy interfejs Gmail.

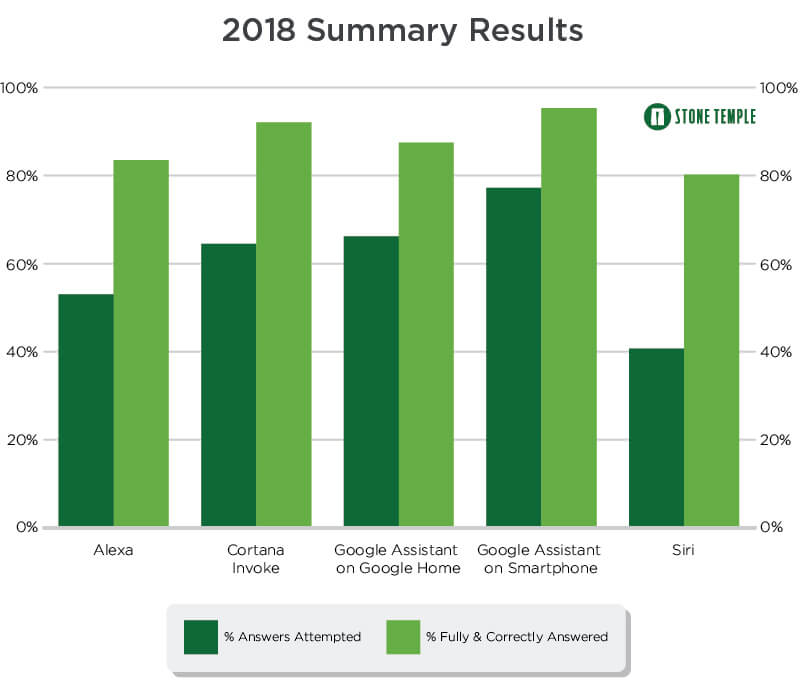

Firma sprawdziła na ile pytań odpowie dany asystent i na ile z nich opowiedział poprawnie. Wyniki były dosyć interesujące. Większość osób jest przekonanych, że Google ma najbardziej sprawny produkt i to zostało potwierdzone. Jednak zaskoczony jestem, że Siri zajęło czwarte miejsce. Oczywiście, popularność nie gwarantuje odpowiedniej jakości, ale wydawało mi się, że Apple kładzie większy nacisk na jakość niż Microsoft i jego Cortana. Nic z tych rzeczy, Siri wypada gorzej i to jest mała niespodzianka.

Żeby dojść do takich wniosków testerzy zadali asystentom 24 410 zapytań. Jest to duża próba i daje już dobry obraz tego co dzieje się na rynku. Na wykresie rozbito Asystenta Google na smartfony i Google Home. Ten drugi wyprzedzony został przez Cortanę, ale na smartfonie nie ma sobie równych. Pomiędzy Cortaną, a Asystentem Google nie ma jeszcze takiej przepaści. Jednak jest ona widoczna już w przypadku Alexy i Siri, przynajmniej jeśli chodzi o same odpowiedzi.

Żeby lepiej zrozumieć wyniki testu trzeba wyjaśnić co oznaczają słupki:

1. Answers Attempted – asystent uważa, że rozumie pytanie i podejmuje wysiłek, by udzielić odpowiedzi. Nie dotyczy to wyników, w których odpowiedź brzmiała: „Nadal się uczę” lub „Przepraszam, nie wiem tego”. Nie dotyczy to również prób, w których asystent mógł nie zrozumieć pytania ze względu na kiepską wymowę lub niewyraźne wypowiedzenie pytania. Chodzi o to, żeby nie wrzucać tutaj wyników, kiedy pytanie zostało usłyszane niepoprawnie. Taki przypadek został sklasyfikowany oddzielnie. Tak zrobiono ze względu na ograniczenie językowa, a nie przez braki językowe.

2. Fully & Correctly Answered – uzyskano poprawną i konkretną odpowiedź na zadane pytanie. Chodzi o precyzyjną odpowiedź, a nie o samo udzielenie suchych faktów. Jeśli zostało zadane pytanie o wiek znanej postaci, to liczyła się odpowiedź o ilość lat interesującej postaci. Jeśli asystent odpowiedział na to pytanie podając datę urodzenia, to wynik traktowano jako błędny.

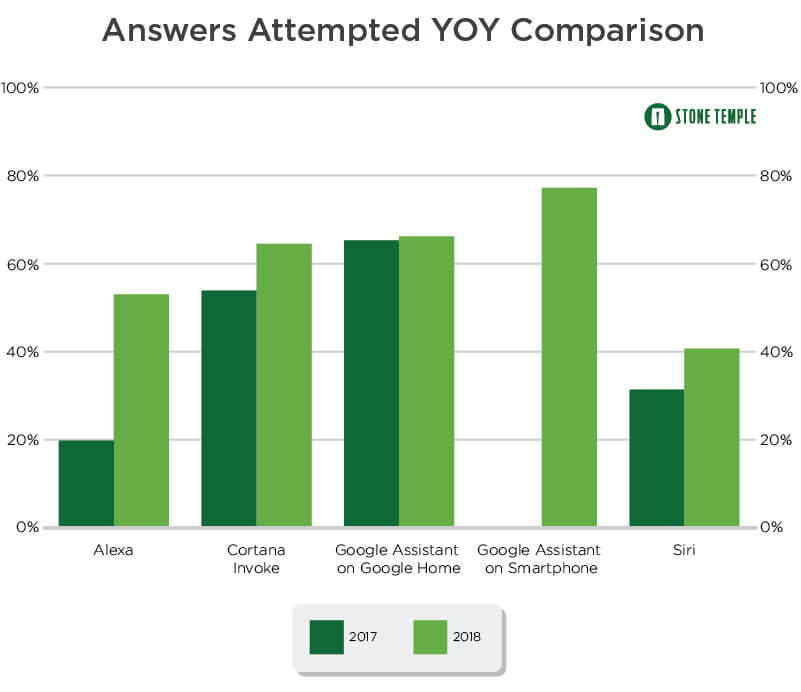

Poniżej równie ciekawy wykres porównujący asystentów z 2017 z obecnymi wersjami. To pokazuje, że uczenie idzie im dobrze. Oczywiście, strony internetowe, na których opierają się wirtualni asystenci, również przeszły tę drogę i są lepiej zoptymalizowane pod tym kątem. Jednak uczenie maszynowe na pewno miało tutaj nie małe znaczenie.

W badaniu zaprezentowano jeszcze wykres porównujący okresy z poprawnymi i konkretnymi odpowiedziami. Tylko Cortana osiągnęła progres w słupkach statystycznych. Jednak osoby odpowiedzialne za testy sugerują, że łatwo było nie zdobyć tutaj punktów. Zapytania są coraz trudniejsze, bardziej skomplikowane i asystenci tak też starają się odpowiadać. Wszystko zmierza do bardziej naturalnej interakcji, a to niesie za sobą szereg różnych potknięć.